决策理论和人工智能通常试图计算类似的东西

$$ \ underset {a \ \ in \ action} {\ mathrm {argmax}} \ \ f(a)。$$

也就是说,最大化动作的某些功能。这倾向于假设我们可以把事情搞得足够复杂,把结果看作是行动的功能。

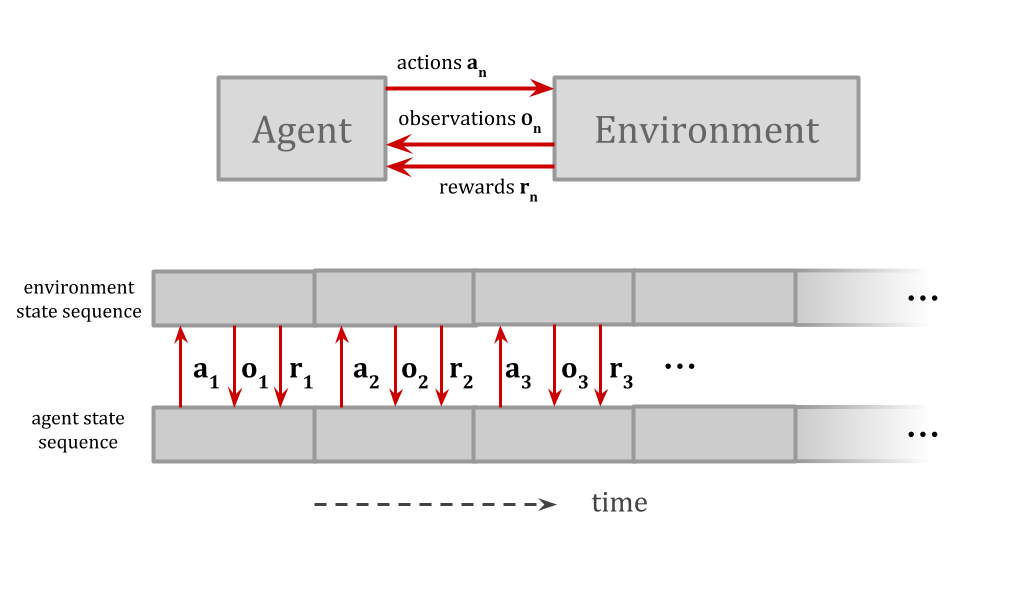

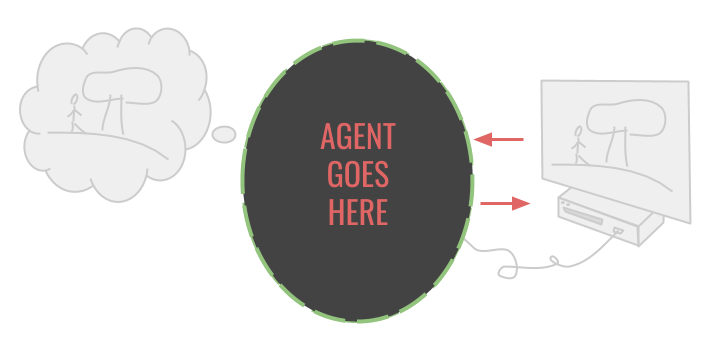

例如,AIXI将代理和环境表示为独立的单元,它们通过明确定义的i/o通道随时间进行交互,这样它就可以选择使奖励最大化的操作。

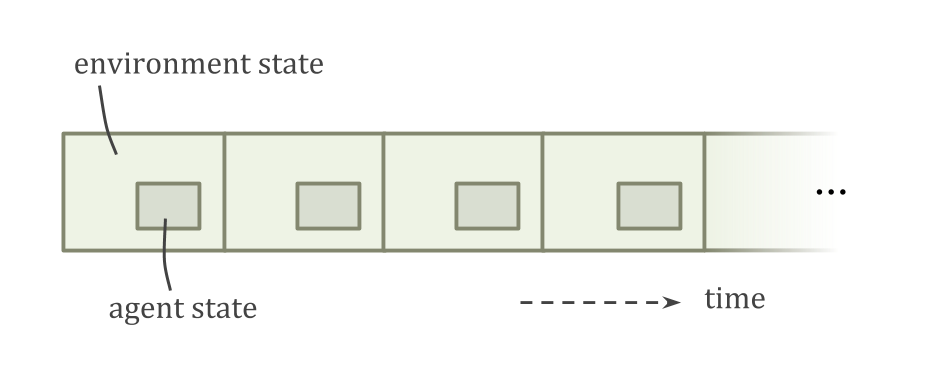

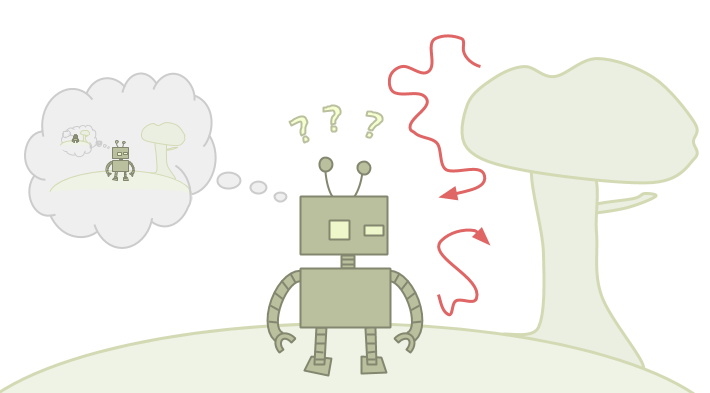

当代理模型是环境模型的一部分在美国,如何考虑采取其他行动就不那么清楚了。

例如,因为代理是小于环境,可以有代理的其他副本,或与代理非常相似的东西。这导致了有争议的决策理论问题,如孪生囚徒困境和纽科姆问题.

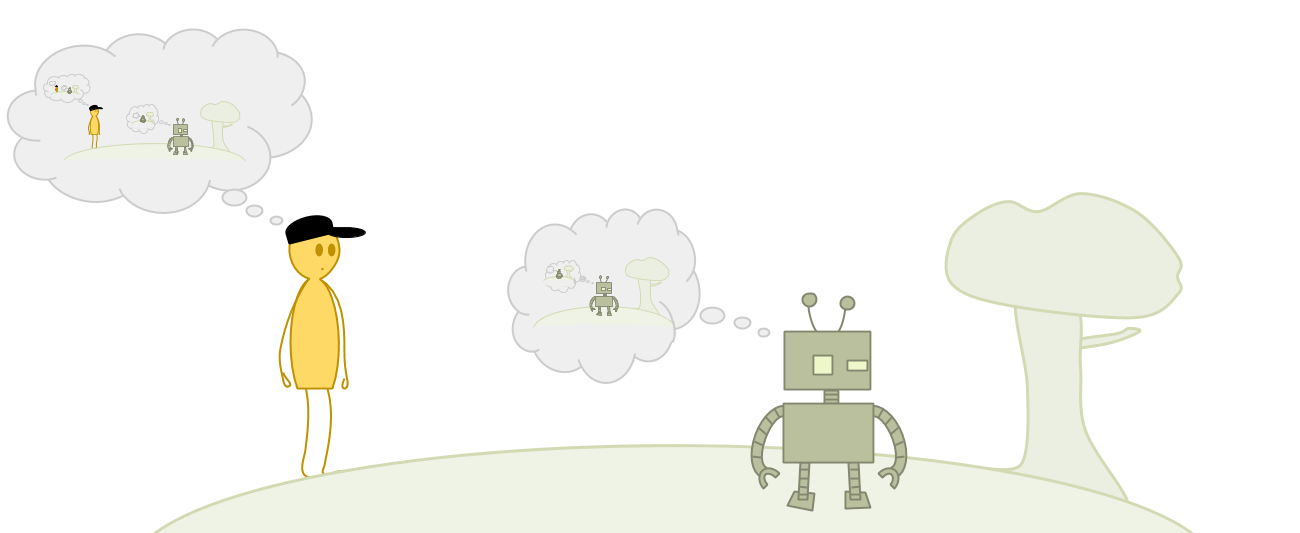

如果埃米模型1和埃米模型2有相同的经验,并运行相同的源代码,埃米模型1是否应该像她的决定是在同时操纵两个机器人?根据你如何在“你自己”周围划分边界,你可能认为你可以控制两个副本的动作,或者只控制你自己的。

这是反事工程问题的一个例子:我们如何评估假设,如“如果太阳突然出去的话”?

- 反应性

- Newcomblike推理,其中代理商与本身的副本相互作用

- 更广泛地推理其他代理

- 敲诈勒索问题

- 协调问题

- 逻辑反设事实

- 逻辑updatelessness

为什么代理需要考虑反事实的最重要的例子来自关于自己行为的反事实。

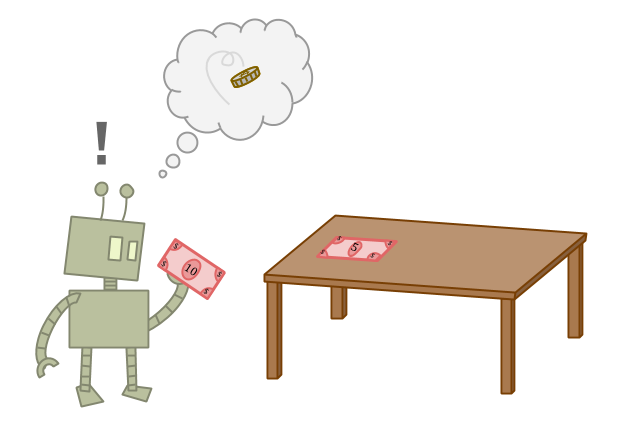

的困难行动反设事实可以用五十八个问题.假设我们有两种选择,一种是5美元,一种是10美元,在这种情况下我们关心的是我们能得到多少钱。显然,我们应该接受这10美元。

但是,它似乎无法降低10美元,这并不容易。

如果你对自己的另一部分成为你自己的理由,那么你可以了解自己的行为.如果你能知道自己的行为,那么如果你表现得会发生什么会发生什么不同的.

这就破坏了许多常见的推理方法。我们如何将“拿走10美元会导致什么?好而拿走5美元会导致的后果坏后果,“当足够丰富的自我知识会将其中一个场景透露出来的一个不一致?

如果我们不能如果把这样的想法形式化,现实世界的特工们是如何想办法拿走这10美元的呢?

如果我们试图计算贝叶斯调节我们行动的期望效用,是常见的,知道自己的行为会导致除错误当我们试图计算行为的期望效用我们知道我们不接受:\ (\ \)lnot意味着\ (P (a) = 0 \),这意味着\ (P (B \ & a) = 0 \),这意味着

$$ p(b | a)= \ frac {p(b \&a)} {p(a)} = \ frac {0} {0}。$$

由于主体不知道如何将自己与环境分离,当它试图想象采取不同的行动时,它就会像齿轮一样吱吱作响。

但是最大的并发症来自Löb的定理,这可以使看起来合理的代理人花5美元,因为“如果我拿10美元,我得到0美元!在A.稳定的方法——agent不能通过更多的学习或思考来解决问题。

这可能很难相信;所以让我们看看一个详细的例子。这种现象可以通过简单逻辑的代理推理关于五十八个问题的行为来说明。

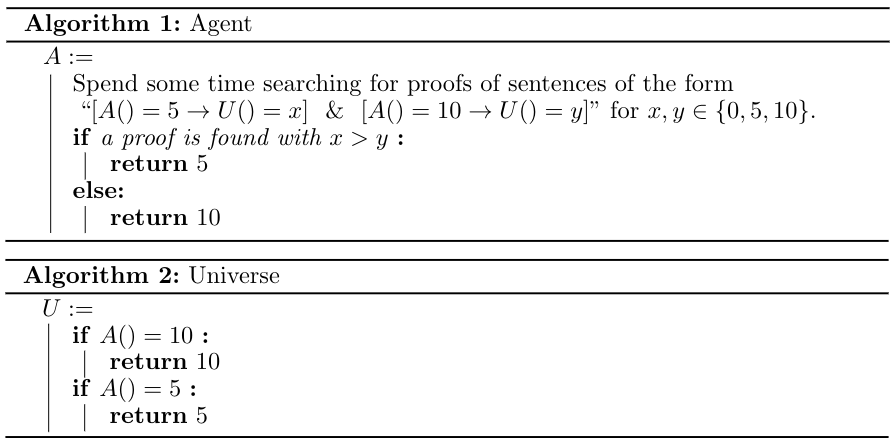

考虑这个例子:

我们有代理和宇宙的源代码。他们可以通过使用quining来互相指代。宇宙很简单;Universe刚刚输出代理输出。

代理将花费很长时间来搜索在它采取各种操作时会发生什么情况的证据。如果某些\(x\)和\(y\)等于\(0\)、\(5\)或\(10\),则证明取\(5\)就会得到\(x)实用程序,取\(10\)就会得到\(y)实用程序,且取\(x>y)就会自然取\(5)。我们希望它不会找到这样的证明,而是选择取\(10\)的默认操作。

当你想象一个代理人试图推理宇宙时,它似乎很容易。然而,事实证明,如果搜索证明的时间量足够,代理将始终选择\(5 \)!

证明这是如此Lob定理.Löb的定理说,对于任何命题\(p \),如果你能证明这一点证明\(p \)意味着真相\(p \),那么你可以证明\(p \)。在符号中,与

“\(□x \)”意思是“\(x \)可证明:

$$□(□p \ to p)\到□p。$$

在我给出的5和10题的版本中,“\(P\)”是命题“如果代理输出\(5\)宇宙输出\(5\),如果代理输出\(10\)宇宙输出\(0)”。

假设它是可证明的,代理最终会找到证明,并返回\(5\)事实上。这就构成了这个句子真的,因为代理输出\(5\),宇宙输出\(5\),而且代理输出\(10)是假的。这是因为像“代理输出\(10\)”这样的错误命题暗示了一切,包括Universe输出\(5 \)。

代理可以(只要有足够的时间)证明所有这些,在这种情况下,代理实际上证明了命题“如果代理输出\(5\),宇宙输出\(5\),如果代理输出\(10\),宇宙输出\(0)”。结果,代理人拿走了5美元。

我们称之为“虚假证据”:代理拿走5美元,因为它可以证明这一点如果它花了10美元,它的价值很低,因为它需要5美元。它听起来很循环,但可悲的是,逻辑上是正确的。更一般地说,在更少的基于证明的设置中工作时,我们将此称为虚假反应性的问题。

一般模式是:反事实可能会假装一个不太好的行动。这使得AI不采取行动。根据反事实的工作原理,这可能会删除任何反馈,这些反馈将“纠正”问题的反事实;或者,正如我们用校对的推理所看到的那样,它可能会积极地帮助虚假的反事实是“真实”。

请注意,因为基于证明的例子对我们来说意义重大,“反事实”实际上必须是柜台逻辑;我们有时需要推理逻辑上是不可能的“可能性”。这条规定了最常见的反事工程推理账户。

你可能已经注意到我有点作弊了。唯一打破对称性并导致代理拿走5美元的原因是“\(5\)”是当证据被发现时所采取的行动,而“\(10\)”是默认的。我们可以考虑这样一个代理,它会寻找任何证据,证明什么行为导致什么效用,然后采取更好的行动。这样,采取哪种行动取决于我们寻找证明的顺序。

让我们假设我们首先搜索短的证明。在本例中,我们将取$10,因为很容易显示\(A()=5\)导致\(U()=5\)和\(A()=10\)导致\(U()=10\)。

问题是,宇宙越来越难以预测时,杂散的证据也可能很短。如果我们用一个明显的功能相同的宇宙取代宇宙,但更难预测,最短的证据将短路复杂的宇宙并保持虚假。

人们经常试图通过建议总会存在一些不确定性来解决反事实的问题。AI可能完美地知道其源代码,但它不能完全了解它运行的硬件。

增加一点不确定性能解决问题吗?通常不是:

- 虚假反事实的证明往往仍然通过;如果你认为你的问题有95%的确定性,那么在这95%的范围内,你可能会遇到通常的问题。

- 添加不确定性以使反事实良好定义不会让您保证反事实将是任何保证合理的.在考虑替代操作时,硬件故障通常不是您希望看到的。

考虑此方案:您有信心您几乎总是占用左路。但是,可以(虽然不太可能)宇宙射线破坏你的电路,在这种情况下你可以右转,但你会疯掉,这将会有许多其他不好的后果。

如果这种推理本身是你总是离开的原因,你错了。

仅仅确保代理对其行为有一些不确定性并不能确保代理将有远为合理的反事实预期。然而,我们可以尝试的一件事是确保代理实际上采取了每一个行动有一些概率。这个策略被称为ε-探索.

ε-探索可以确保,如果一个agent在足够的情况下玩类似的游戏,它最终可以学习到真实的反事实(模a关注可实现性我们稍后会讲到)。

只有当ε探测试剂本身不能预测其是否要进行ε探测时,ε探测才能起作用。实际上,实施ε-探测的一个好方法是通过“如果主体对其行动过于确定,就采取另一种行动”这条规则。

从逻辑的角度来看,ε-勘探的不可预测性是防止我们一直在讨论的问题。从学习理论的角度来看,如果代理人可以知道它不应该探索,那么它可能会将其视为不同的案例未能概括其探索的课程。这让我们回到了我们无法保证代理人会学到更好的反应性的情况。探索可能是某些行动的唯一数据来源,因此我们需要强制代理人考虑该数据,或者它可能无法学习。

但是,即使是ε-探测似乎没有完全正确的东西。观察ε-探索的结果显示,如果你采取行动,会发生什么不可预知的;作为“一切照旧”的一部分采取这种行动的后果可能会有所不同。

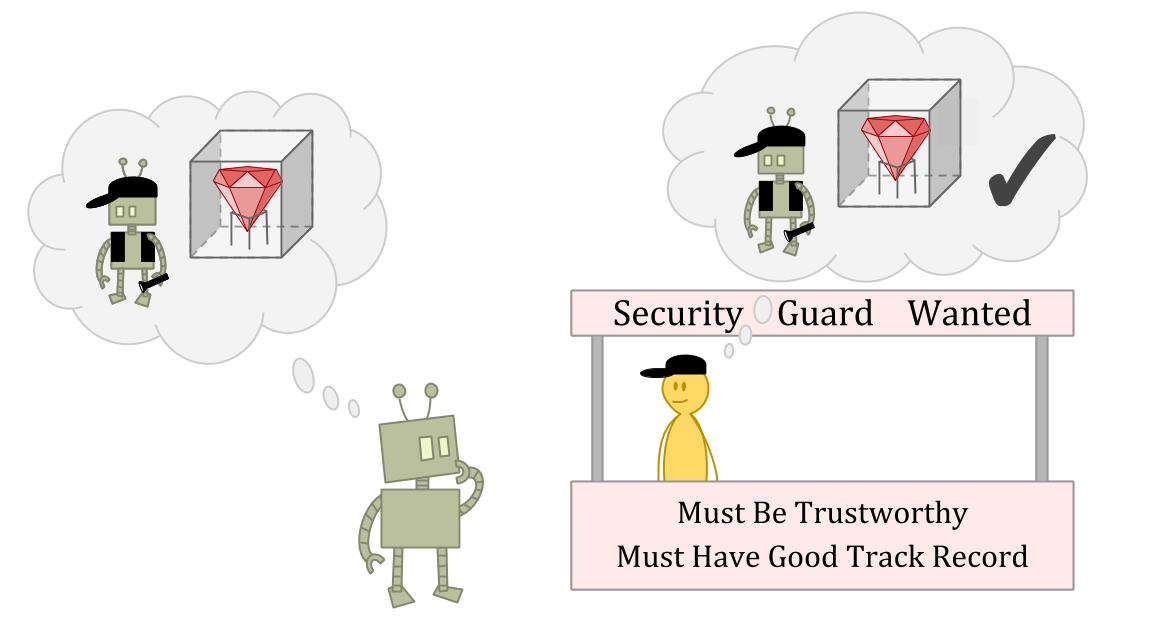

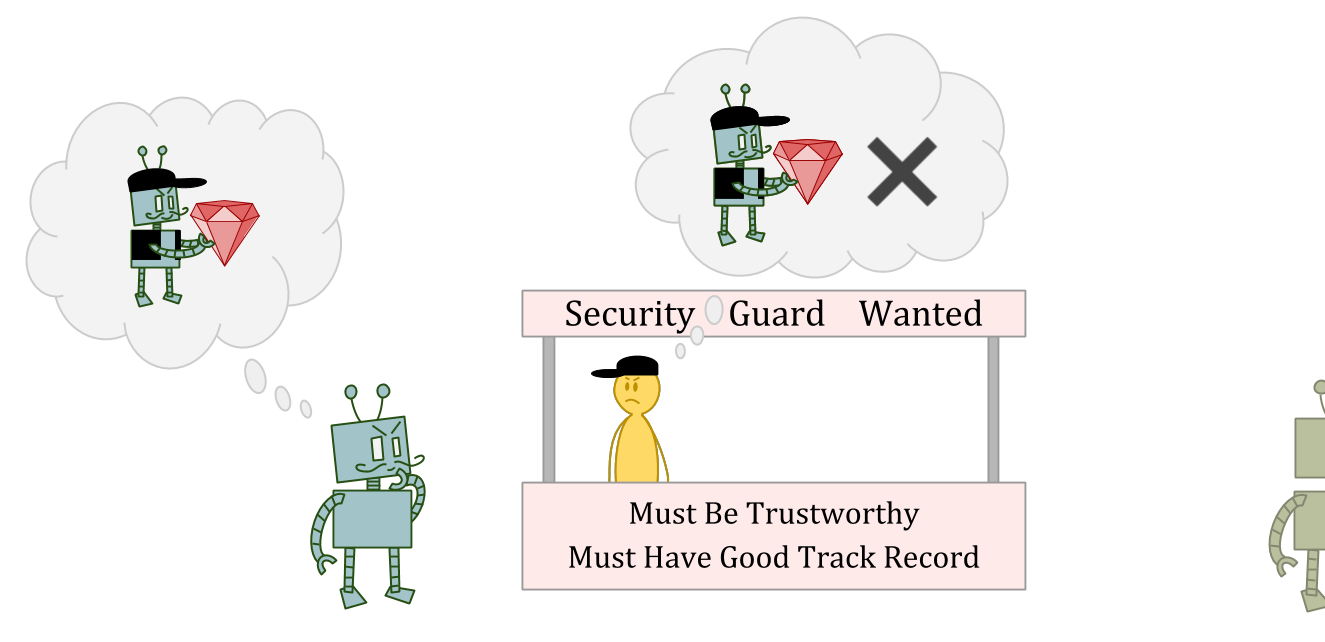

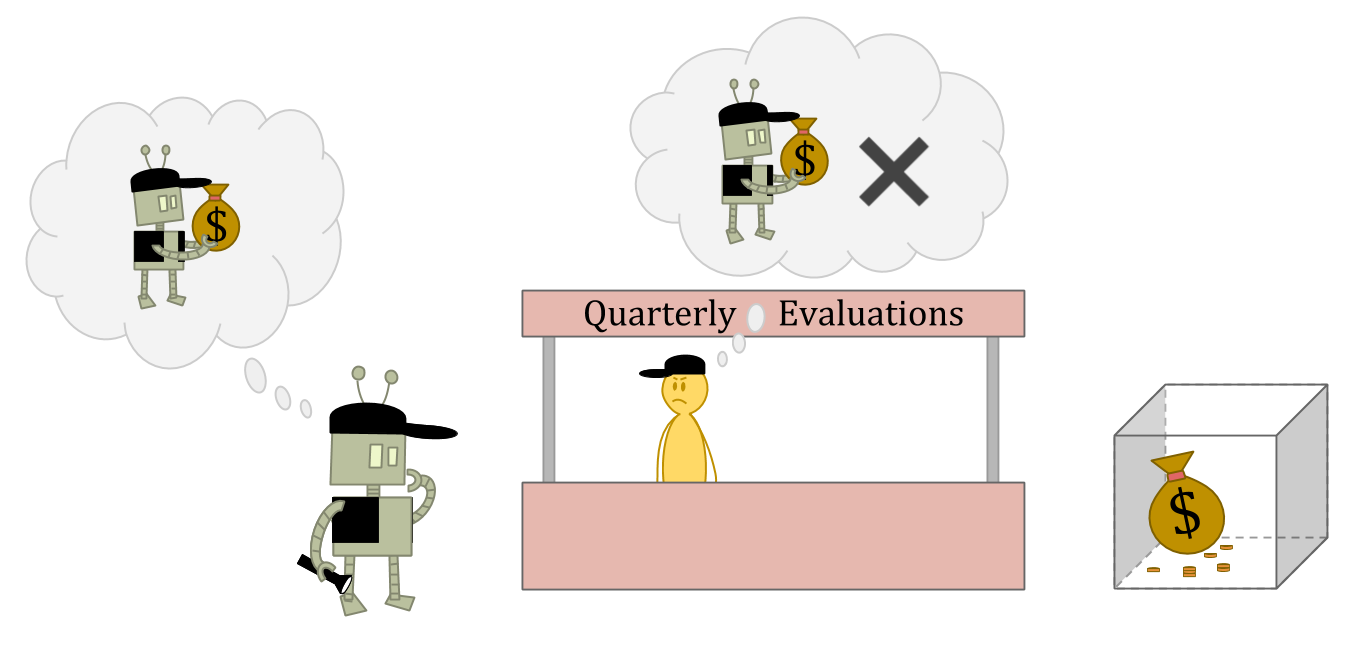

假设你是一个生活在一个Ε-exporers世界的explorer。您正在申请作为保安人员的工作,您需要说服面试官,即您不是那种与您守卫的东西遇到的人。他们希望雇用一个过于诚信的人来撒谎和偷窃,即使这个人认为他们可以逃脱它。

假设面试官是一个出色的性格判断者——或者只是读过你的源代码。

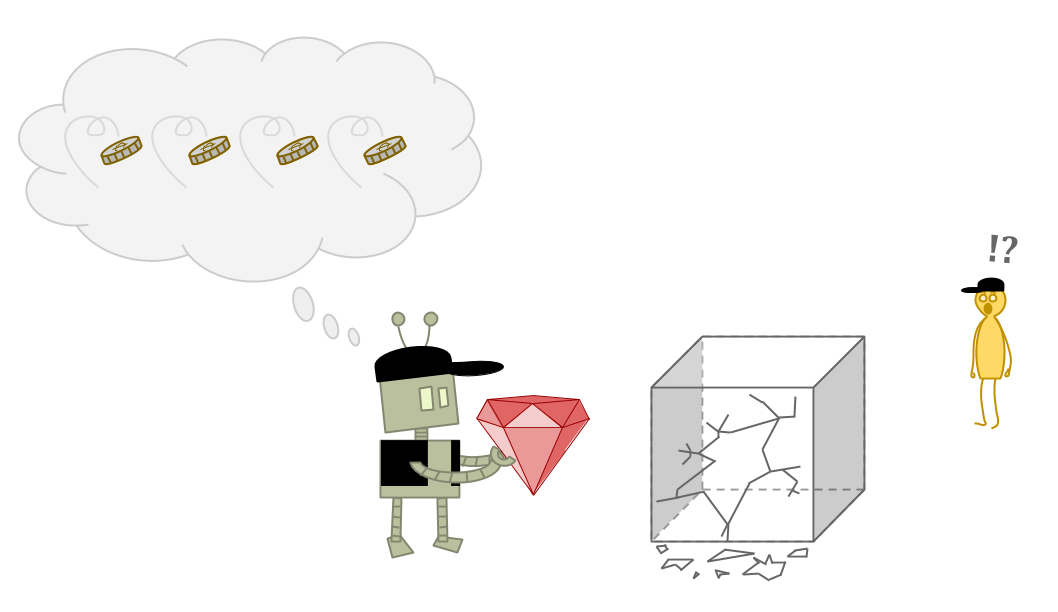

在这种情况下,偷窃可能是一个很好的选择作为ε-勘探行动,因为面试官可能无法预测你的偷窃行为,或者可能认为惩罚一次异常行为没有意义。

但偷窃显然不是好主意作为一个正常的行为,因为你会被认为是不可靠和不值得信赖的。

如果我们不能从ε-探索中学习到反事实,那么我们似乎根本无法保证学习到真实的反事实。但是,即使我们确实从ε-探测中得到了教训,似乎我们在某些情况下还是会出错。

切换到概率设置不会导致代理可靠地做出“合理的”选择,也不会强制探索。

但写下“纠正”的例子的例子,从外面似乎似乎困难!

也许这是因为从“外部”来看,我们总是有一个二元论的视角。我们实际上是在问题之外,我们把它定义为一个agent的函数。

但是,代理商无法以与内部相同的方式解决问题。从其角度来看,与环境的功能关系不是可观察的事实。这就是为什么反事实却被称为“反事实”的原因。

当我告诉你关于5和10个问题的时候,我第一次告诉你关于这个问题,然后给了你一个代理人。当一个代理商不起作用时,我们可以考虑一个不同的代理人。

要想在决策问题上取得成功,需要找到一个代理,当插入问题时,代理会采取正确的行动。事实上,我们甚至可以考虑放入不同的主体,这意味着我们已经将宇宙划分为一个“主体”部分,再加上宇宙的其他部分中有一个主体的洞——这是我们的大部分工作!

我们只是由于我们设置了决策问题的方式欺骗自己?没有“正确”的反应性?

好吧,也许我们是在欺骗自己。但是仍然有一些事情让我们感到困惑!"反事实是主观的,由代理人发明的"并不能解开谜团。有的东西在现实世界中,智能代理做决定。

所以我不是在谈论知道自己行动的代理,因为我认为智能机会将来会有一个大问题推断他们未来自己的行为。相反,了解自己行为的可能性说明了关于确定你的行为的后果的事情 - 即使在非常简单的情况下也出现的混乱,这是一个关于世界的一切都知道,你只需要选择更大的金钱。

为了这一切,人类似乎没有遇到10美元的麻烦。

我们可以从人类做出决定中获取任何灵感吗?

假设你被要求在10美元和5美元之间选择。你知道你会接受这10美元。你如何推理什么将如果你拿了5美元呢?

如果你能将自己与外界隔离开来,只考虑外部后果(比如得到5美元),这似乎很简单。

如果你想一想你自己同样,反事实开始显得有点奇怪或矛盾。也许你会有一些荒谬的预测,如果你拿了5美元,世界会变成什么样子,比如,“我要变成瞎子了!”

不过,没关系。最后你仍然看到拿走5美元会导致不好的结果,你仍然拿走了10美元,所以你做得很好。

The challenge for formal agents is that an agent can be in a similar position, except it is taking the $5, knows it is taking the $5, and can’t figure out that it should be taking the $10 instead, because of the absurd predictions it makes about what happens when it takes the $10.

一个人似乎难以结束这样的情况;然而,当我们尝试编写正式的通知员时,我们继续遇到这种问题。所以它确实看起来像是人类决策正在这里做某事,我们尚未理解。

如果你是一个嵌入式代理,那么你应该能够考虑自己,就像你想到环境中的其他对象一样。您的环境中的其他资料也应该能够思考你。

在五十五的问题中,我们看到了代理在它行为之前了解自己的行动时,事情会如何获得杂乱。但这很难避免嵌入剂。

在标准贝叶斯设置下,很难不知道自己的行为,哪一种假设是逻辑上的无所不知.概率分布将概率1赋给任何逻辑上正确的事实。如果是贝叶斯代理知道自己的源代码然后它应该知道自己的行动。

但是,在逻辑上无关的现实代理可能会遇到同样的问题。逻辑禁止迫使问题,但拒绝逻辑的无所作为不会消除问题。

ε-探索做似乎在许多情况下解决了这个问题,通过确保代理对他们的选择有不确定性,并且他们期望的事情是基于经验。

但是,正如我们在保安例子中所看到的,当随机探索的结果与可靠行动的结果不一致时,ε-exploration似乎也会误导我们。

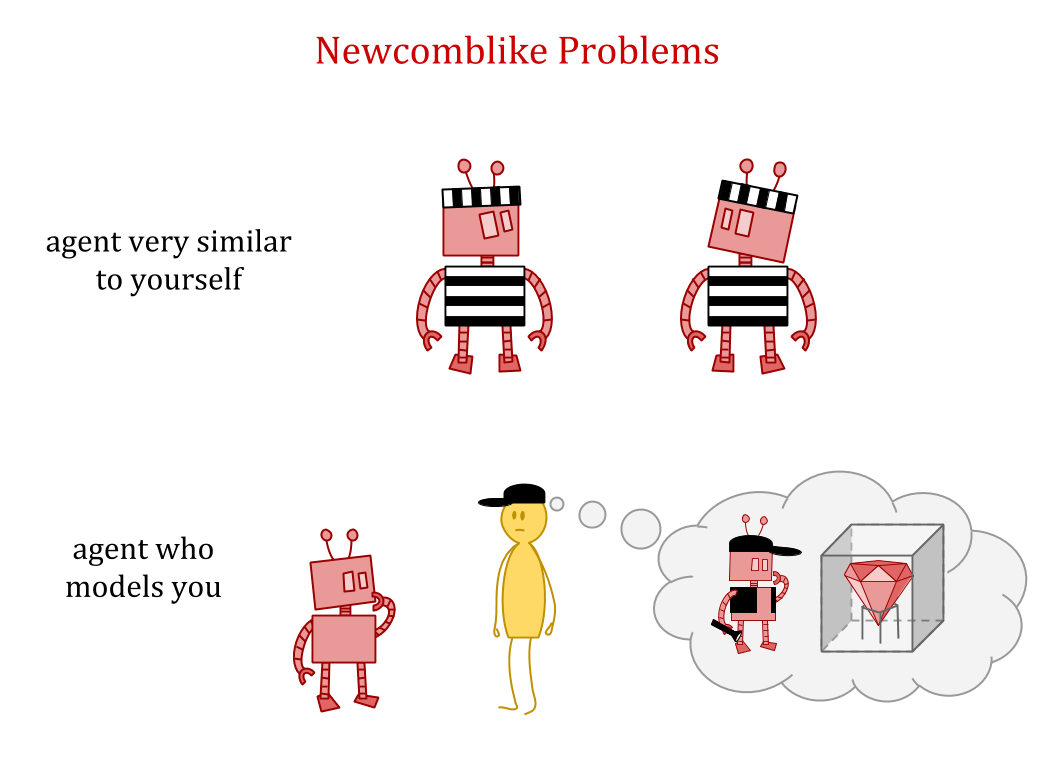

以这种方式出错的例子似乎涉及到环境的另一部分,它的行为与你类似,比如另一个与你非常相似的主体,或者一个足够好的模型或模拟你。这些被称为Newcomblike问题;上面提到的孪生囚徒困境就是一个例子。

如果5加10的问题是关于从世界中切割出一个u型的部分这样世界就可以被看作是你行为的函数,那么newcombu类问题是关于当世界中有几个近似的u型部分时该怎么做。

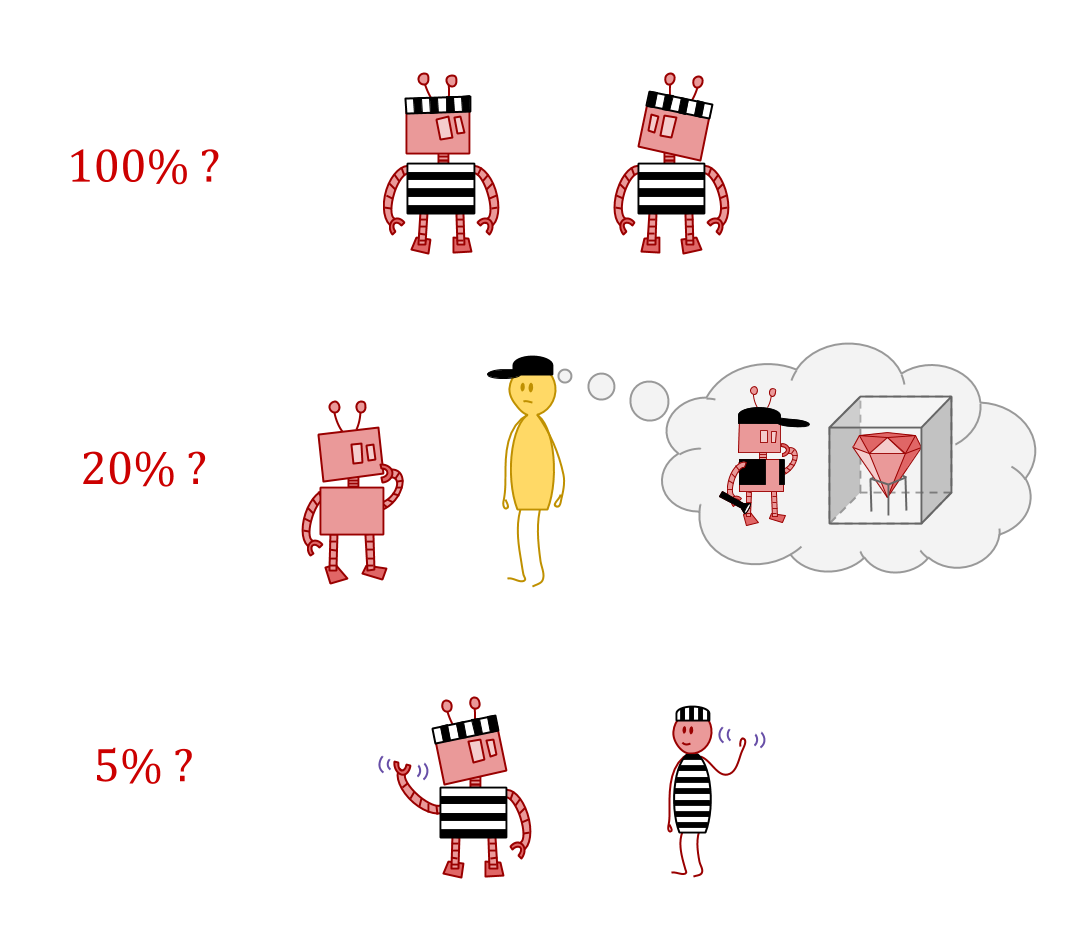

一种观点是精确的副本应在你的“逻辑控制”下100%处理。对于近似模型的你,或仅仅相似的代理人,控制应该急剧下降逻辑相关性减少。但这是如何工作的?

与迄今为止所讨论的自我参照问题一样,newcombi类问题的困难原因几乎相同:预测。通过ε-探索等策略,我们试图限制大学生的自我认识代理试图避免麻烦。但是环境中强有力的预测因子的存在重新引封了麻烦。通过选择要共享的信息,预测器可以操纵代理并为它们选择其操作。

如果有什么东西可以预测你,它可能告诉您是预测,或相关信息,在这种情况下,它对您做了什么在回应中你可以找到各种各样的东西。

假设您决定与您所说的任何事情相反。然后,不可能首先设置场景。毕竟预测器并不准确,或者可选地,预测器不与您共享他们的预测。

另一方面,假设在某些情况下你确实按照预期行事。然后预测者就可以控制你的行为,通过控制他们告诉你的预测。

所以,一方面,一个强大的预测器可以通过在一致的可能性中进行选择来控制你。另一方面,你是第一个选择你的反应模式的人。这意味着你可以让他们达到你的最佳优势。

到目前为止,我们一直在讨论行动反应性 - 如何预测不同行动的后果。这种控制答复的讨论介绍了观察反事实的想象如果观察到不同的事实,这个世界会是什么样子。

即使没有人告诉你关于你未来的行为的预测,也可以在做出正确的决定方面发挥作用。考虑以下游戏:

爱丽丝随机收到一张牌,是高牌还是低牌。如果她愿意,她可以把牌露出来。然后Bob给出Alice有一张大牌的概率\(p\)。爱丽丝总是输(p^2)美元。如果牌数低,Bob会输掉\(p^2\),如果牌数高,Bob会输掉\((1-p)^2\)。

鲍勃有一个适当的评分规则,通过给予他的真实信仰来说最好。爱丽丝只希望鲍勃的信念尽可能地走向“低”。

假设爱丽丝只会玩这个时间。她看到一张低牌。鲍勃善于推理爱丽丝,但在下一个房间,所以无法阅读任何讲述。爱丽丝应该透露她的卡吗?

因为爱丽丝的牌低,如果她把牌给鲍勃,她就不会输钱,这是可能的最佳结果。然而,这意味着在反事实的世界里,爱丽丝看到一张高牌,她就不能保守秘密——在这种情况下,她可能也会把她的牌露出来,因为她不愿露出来是“高”的可靠标志。

另一方面,如果Alice没有展示自己的纸牌,她将损失25美分,但她也可以在另一个世界中使用相同的策略,而不是损失1美元。所以,在玩游戏之前,爱丽丝会明确承诺不透露;这使得预期损失为25美分,而其他策略的预期损失为50美分。通过将观察到的反事实考虑在内,爱丽丝能够保守秘密——没有它们,鲍勃可以从她的行动中完美地推断出她的牌。

这个博弈等价于决策问题叫做反事实抢劫.

Updateless决策理论UDT (UDT)是一种在高/低牌博弈中能够保守秘密的决策理论。UDT通过建议代理做以前看起来最明智的事情来做到这一点——无论您的早些时候的自我会承诺去做的事。

碰巧的是,UDT在newcombi类问题中也表现得很好。

像UDT这样的东西是否与人类正在做的事情相关(如果只是含蓄地),从而在决策问题上获得良好的结果?或者,如果不是,它是否仍然是一个思考决策的好模型?

不幸的是,这里仍有一些相当深刻的困难。UDT是对相当广泛的决策问题的优雅解决方案,但它只有在早期的自我能够预见的情况下才有意义所有可能的情况下.

这在贝叶斯的环境中工作正常,其中已在其中包含在本身内的所有可能性。但是,可能无法在现实的嵌入式设置中执行此操作。代理人必须能够想到新的可能性- 它的早期自我不太了解所有决定。

这样一来,我们就可以直面问题了嵌入式世界型号.

你喜欢这篇文章吗?你可以享受我们的其他分析帖子,包括: